Prompt Chaining (Encadenamiento de Prompts)

Imagina que en lugar de un LLM (un modelo de lenguaje), tienes una línea de ensamblaje para fabricar un producto complejo, como un coche.

Sería una locura pedirle a un solo super-trabajador que construya el coche entero desde cero. Es muy probable que cometa errores, se olvide de piezas o tarde una eternidad.

Lo que haces es dividir el trabajo:

- Un trabajador pone el chasis.

- El siguiente pone el motor.

- El siguiente instala las ruedas.

- Y así sucesivamente...

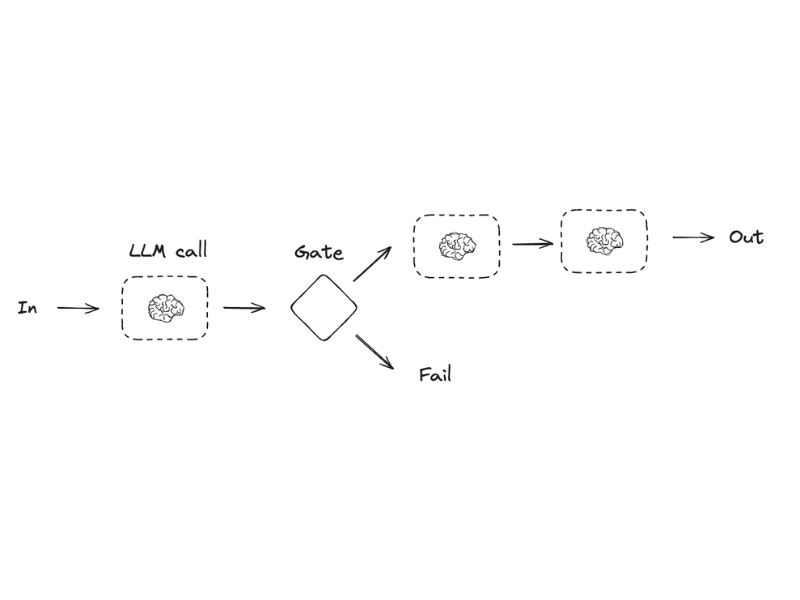

El Prompt Chaining (Encadenamiento de Prompts) es exactamente eso. En lugar de darle una tarea gigante y compleja al LLM en un solo prompt, divides la tarea en una cadena de pasos más pequeños y manejables.

- Cada llamada al LLM es un "trabajador especialista" que hace una sola cosa bien.

- La "salida" (output) del primer trabajador se convierte en la "entrada" (input) del siguiente. El que pone las ruedas necesita el coche con el motor ya puesto.

- El "Gate" (Compuerta): Esto es como el inspector de calidad entre cada estación. Antes de pasar a la siguiente fase, un programa simple (no la IA) revisa si el trabajo anterior se hizo bien. ¿El motor está bien ajustado? Si no, se detiene la producción. Esto asegura que los errores no se arrastren.

En resumen: Sacrificas un poco de velocidad (latencia), porque son varios pasos, pero ganas muchísima confiabilidad y precisión, porque cada paso es mucho más fácil de ejecutar correctamente.

Ejemplo Real: "Asistente para crear artículos de Blog"

Imagina que quieres una IA que te ayude a escribir un artículo completo sobre un tema.

❌ El mal enfoque (un solo prompt gigante):

"Escribe un artículo de blog completo, bien estructurado y optimizado para SEO sobre 'Los beneficios de la meditación para reducir el estrés', con una introducción, tres puntos principales con ejemplos y una conclusión."

Este enfoque es arriesgado. La IA podría generar un texto de baja calidad, olvidar alguna sección o no estructurarlo bien.

✅ El buen enfoque (Prompt Chaining): Aquí dividimos la tarea en una cadena de especialistas.

Paso 1: El Brainstormer (LLM Call #1)

- Input:

"El tema es: Los beneficios de la meditación para reducir el estrés" - Prompt:

"Genera los 3 puntos principales o subtemas para un artículo sobre este tema. Responde solo con una lista." - Output (Ejemplo):

1. Reducción del Cortisol y la Respuesta Fisiológica al Estrés. 2. Mejora de la Claridad Mental y el Enfoque. 3. Aumento de la Resiliencia Emocional a Largo Plazo.

(Aquí iría nuestra "Gate" o Compuerta)

- Lógica del programa: ¿El resultado del Paso 1 es una lista? ¿Tiene 3 puntos? Si la respuesta es sí, continuamos. Si la IA respondió con un párrafo largo, detenemos el proceso porque el siguiente paso fallaría.

Paso 2: El Escritor (LLM Call #2)

- Input: La lista generada en el Paso 1.

- Prompt:

"Escribe un párrafo desarrollado y con ejemplos para cada uno de los siguientes puntos: [Pegamos aquí la lista del Paso 1]" - Output: El cuerpo principal del artículo, bien desarrollado.

Paso 3: El Titulador (LLM Call #3)

- Input: El texto completo generado en el Paso 2.

- Prompt:

"Basado en el siguiente artículo, genera 5 títulos atractivos y optimizados para SEO." - Output: Una lista de posibles títulos para el blog.

Resultado Final: En lugar de un solo "mega-prompt" que podría fallar, creamos una cadena confiable donde cada especialista hizo su trabajo a la perfección, asegurando un resultado final de alta calidad.